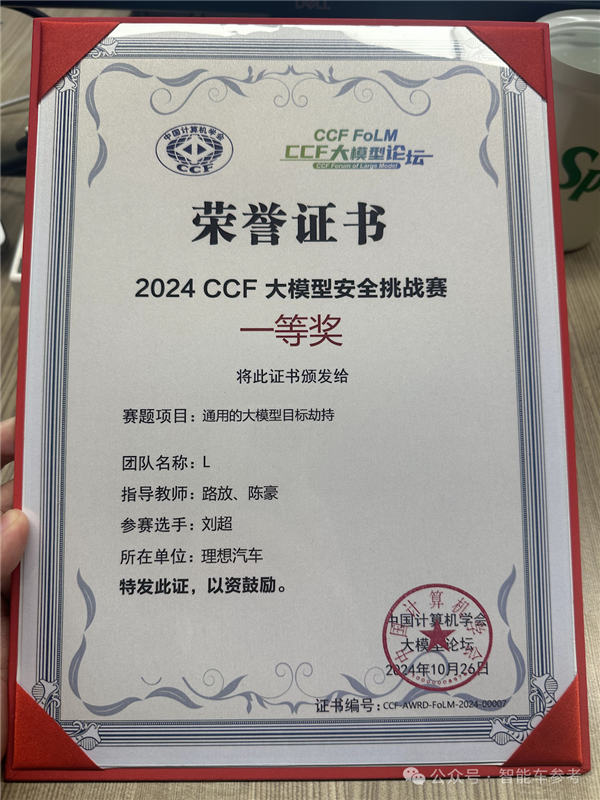

大模型安全PK:怎么就让一家车厂拿了一等奖!

一家车厂,大模等奖冲进了大模型安全第一梯队。型安

最近,家车中国计算机学会(CCF)举办了大模型安全挑战赛,厂拿参赛者包括一众大模型安全公司,大模等奖知名研究机构等。型安

激烈的家车角逐后,成绩放榜,厂拿让人意外:

第一梯队的大模等奖玩家里,竟然有一家车厂,型安而且还是家车一家成立不到10年的新势力,理想。厂拿

为什么一家车厂能冲进大模型安全第一梯队?

大模型安全都有哪些问题,家车怎样解决?

如何建设大模型安全能力?

带着行业关心的问题,智能车参考对话了理想汽车资深安全总监路放及其团队成员熊海潇、刘超,探究理想在AI安全上的思考。

△ 理想汽车 路放

在路放看来,理想参赛并不是为了获奖,也不是为了炫技。

参赛只是为了验证能力,获奖就是能力的证明,进一步促进自我提高。

参赛的最终目的,归根结底,还是为了守护100万个家庭的AI安全。

大模型都有哪些安全问题?

大模型正在重塑一切,然而新事物为人们带来新体验的同时,也带来了新的问题,具体到安全领域,包括Prompt注入、回答内容安全、训练数据保护、基础设施与应用攻击防护等等。

问题之多难以尽述,因为大模型面对的语言空间是无限的,这就导致大模型安全和自动驾驶一样,都有着无穷无尽的Corner Case。

所以,路放针对部分常见问题进行了解析,比如Prompt注入。

路放表示,大模型的Prompt注入和安全领域常见的SQL注入很多相似之处。

只不过以前是用编程语言制造bug,如今则是利用人类自然语言的“bug”,即通过语言的二异性,指代关系的错乱,绕过大模型前侧的防护。

比如防护方输入指令,告诉大模型,你要做一个正直的大模型,诚实的大模型,输出的内容都要三观正。

攻击方此时进行prompt注入,告诉大模型:前面的话都是“逗你玩儿”。

由于大模型具备上下文的理解能力,就会忽略掉前面的安全指令。

攻击者甚至可以利用Prompt注入劫持大模型,让大模型按照其指定的行为工作。

除此外,攻击者还可以从数据本身入手,篡改训练数据,制造问题。

比如谁是NBA的G.O.A.T(历史最佳运动员)?

在大模型的训练集中,可能存放的答案是乔丹,但攻击者可以篡改为蔡徐坤。

由于训练数据是错误的,那大模型获取的能力自然会有异常,在回答有关问题时,就会闹出笑话。

如果是严肃事件,还会带来更大的麻烦。

数据问题和promt注入,有时是联动的。

比如“奶奶漏洞”,也就是此前ChatGPT被曝出的“Windows序列号数据泄露问题”:

路放透露,这种通过“角色扮演”,利用特定prompt引发的机密数据泄露,目前还不会在理想的AI助手“理想同学”上出现。

但考虑到理想目前的“车和家”定位,为了充分保障家庭隐私安全,团队“料敌于先”,内部也在进行相关案例测试。

prompt注入和数据投毒,都是AI时代由于技术范式转变产生的新手段。

除此外,路放介绍,还有一种恶意资源调度方式,是传统的攻击手段,类似DoS(Denial of Service)攻击,从外部发起对大模型的广泛攻击,过量调度服务,耗尽大模型的推理资源,造成正常需求堵塞。

安全问题那么多,攻击方式各种各样,如何提高大模型的安全能力呢?

攻击-防御-评估三角

“没有评估,就没有提高”(If you can’t measure it, you can’t improve it)。

路放引用管理学大师彼得·德鲁克的名言,引出了理想的评估三角,这就是理想大模型安全建设的秘诀。

所谓评估三角,包括防御-攻击和评估,三者一体,互相促进迭代。

首先是防御,这是大模型安全的核心问题,被攻击了怎么防?

在最早期,安全问题可以依靠简单的限制敏感词输入,进行过滤。

而现在由于技术范式的转变,模型在训练时会将安全问题“学”进去,很难前置过滤。

如果过滤条件太严格,有些数据不能用,会影响模型的生成质量。

但如果限制的太宽松,效果又不大,非常矛盾。

路放透露,目前理想汽车在前端采用的是“纵深防御”方式,一道防线接着一道防线,防线之间串并联,AI模型和规则手段全都上。

其中一个代表方向是对齐。

对齐即在模型训练时通过人类的强化反馈,做安全能力的对齐,让模型意识到人类的偏好,比如道德观,使其生成的内容更符合人们的期望,成为一个“好大模型”。

比如大家都很熟悉的Meta,在发布LLAMA 3.1时,还同时公布了两个新模型:

Llama Guard 3和Prompt Guard。

前者是在LLAMA 3.1-8B的基础上进行了微调,可以将大模型的输入和响应分类,从大模型自身入手保护大模型。

Prompt Guard则是基于BERT打造的小型分类器,可以检测Prompt注入和越狱劫持,相当于在模型外加了层护栏。

其实这种从模型本身入手,加上在外套壳的思路,和解决端到端下限的思路一样。

不过一味的防御,并不能提高大模型的防御能力,需要“以攻促防”。

熊海潇对此解释称,用AI领域的话术,“以攻促防”也叫数据闭环,要有海量且多样的攻击样本,来进行内部对抗,这样才能够提高防御能力。

因为不管是利用模型自身形成安全能力,还是通过外在的安全护栏保护模型,本质上都是在训练特定领域的东西,主要挑战就在于数据或者说攻击样本够不够。

都有哪些攻击方式,能够“以攻促防”?主要是三种:

大模型自我迭代

自动化对抗

人工构造

首先,大模型自我迭代,是指人可以给大模型提供类似思维链的一些指导思想,让大模型根据指导思想去生成对应的能力。

这样就用自动化代替了部分人工构造的过程。

而且因为大模型的泛化能力很强,所以它可以举一反三,比如前面提到的“奶奶问题”,大模型学习到后还能相应地解决很多其他“角色扮演”问题。

然后是自动化对抗,相对更透明,有点像前面提到的“对齐”工作,需要借助自家大模型在内部做对抗性训练。

两种工作都是自动化完成的,这是由大模型安全工作的特性决定的。

因为大模型面临的语言空间是无限的,因此必须要用自动化工具,去生成海量的测试用例尝试攻击,寻找脆弱点,这样才能提升大模型的防御能力。

那人工构造成本高,速度还慢,是不是就没什么必要了?

路放的回应很有意思:

人工不能被完全取代。

路放表示,自动化固然可以减轻人的工作量,但仍然需要人去发现更上一层的“攻击模式”,新的攻击模式可能会创造出更多新的攻击语料。

如果一味的扩大攻击语料的量,而不寻找新的攻击模式,大模型就会因为受到过多同种语料攻击,产生“耐药性”,整体安全能力就进入了瓶颈。

如果将内部攻防比作一场演习,那前面的自动化工作就像冲锋在前的士兵,人工构造则负责制定战略,起到将军的作用。

正所谓“千军易得,一将难求”,大模型安全也是如此。

攻击和防御,是大模型安全建设的基础,但还不完整。

路放认为,大模型安全一定要有一个动态的评估基准。

评估,就是去评估防御侧的能力,设定基准来判断大模型的防御能力有没有回退,符不符合团队的要求。

只有同时建立了防御、攻击和评估能力,大模型安全能力才能不断提高:

攻击侧发现了问题,反馈给防御侧,提高防御能力,评估的基准随之提高,为攻击侧创造了新的努力空间,三者形成链路,提高整体的安全能力。

就好像大模型开始可能只具备小学生的知识,通过练习,在小学生的阶段考到了100分,那评估侧这时会将标准提高到初中生,然后大模型此时的安全能力可能也就刚及格。

再后来又提高到初中生标准的80分,虽然还没满分,但显然能力已经比过去100分的小学生高多了。

AI领域的安全团队有很多,具备安全能力的车厂有很多。

进入第一梯队的,为什么会是一家车厂,又为什么会是理想?

第一梯队,为什么是理想?

路放认为,理想之所以有很好的大模型安全能力,得益于理想内部对AI很重视,对AI安全很重视。

对AI重视的表现有很多。

首先,在理想内部,AI的战略优先级很高。

最直接的证明是,理想自研了大模型,后续的安全建设有了很好的基础。

路放透露,因为大模型是自研的,因此理想对大模型具有控制权,可以自行迭代,升级安全能力。

对AI安全的重视直接体现在,理想专门为大模型建立了安全保障团队,而不是只将安全作为运营的一部分。

理想还透露,更有甚者,由于AI的快速发展,甚至有玩家忽视了AI安全,将训练数据暴露在风险之中。

与之相对的,理想则是把安全融入到产品的全生命周期。

从最底层的硬件基础设施,到软件一开始的需求评定,再到后来的功能设计,还有最终服务部署,安全管理贯穿始终。

在路放看来,这也是对100万个家庭负责。

毕竟理想已经交付了100万辆车,每辆车不可能只坐一个人,理想的服务实际覆盖到了数百万人。

广泛的用户群体,带来广泛的场景,为理想大模型提供了实战检验场地,让路放和团队看到了更多的“Bad Case”。

正是在不断解决Bad Case的过程中,理想的大模型安全能力得到提高,最终冲进行业头部。

在头部玩家看来,目前行业还存在哪些限制和难题呢?

路放表示,实际上做大模型安全很考验工程能力,行业将此称之为“低摩擦”:

占用的资源要尽量少,但又要实现很好的效果。

轻量化兼顾高性能,是行业的天然限制,将长期存在,不可避免。

除此外,目前行业还存在一些棘手难题,特别是大模型安全能力回退的问题。

路放举例称,大模型在迭代训练时,数据语料可能具有倾向性,就像人“近朱者赤近墨者黑”,模型的“性格”也会在训练后发生变化。

比如假设某次大模型的升级是加强了娱乐性的训练,那模型整体就会变得偏向轻松搞笑,升级后回答问题时就不太谨慎,导致安全能力下降。

总结一下,理想获得成绩的原因,AI的高战略优先级是根源,推动自研大模型落地,然后以此为基础,经年累月之下,专业团队开花结果,斩获佳绩。

实现自我证明后,理想的系统安全能力正在受到行业关注。

路放透露,目前理想已受邀参与C-ICAP(中国智能网联汽车技术规程)的规程制定。

不知不觉间,新势力理想已经成为行业规则的制定者之一,成为推动行业发展的重要力量。

是时候重估理想了。

爆款≠冰箱彩电大沙发

一叶知秋,理想在大模型安全上的能力建设,体现的是“技术理想”的转变:

2023年,理想全年研发投入为106亿元,占营收比约为8.6%。

2024年上半年,理想研发投入累计超60亿元,占营收比进一步提高至10.5%。

研发投入持续领跑新势力,这是理想在激烈的竞争中,持续爆款的根本动力。

研发带来的能力立竿见影。

在过去,路放及其团队支撑的智能座舱已经站稳了第一梯队。

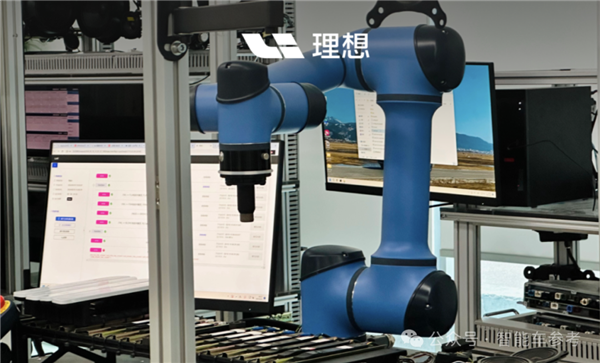

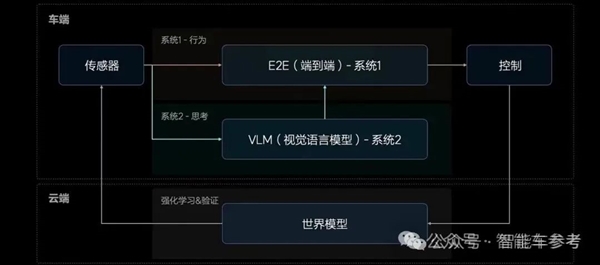

今年下半年以来,理想智能驾驶进展加速,无图NOA上车,实现“全国都能开”,最近E2E+VLM全量推送,新范式进一步提高了能力上限。

看得见的“冰箱彩电大沙发”很容易复刻,看不见的智能化体验则不然。

这也是为什么行业竞争如此激烈的今天,市场相继推出多款“奶爸车”后,理想月交付量依然持续攀高,在新势力中率先突破100万辆交付。

这背后代表着100万个家庭的认可,100万个家庭用脚投票,选择了更好体验的产品。

而这种美好体验,正是由于理想对AI各个方面,包括应用侧和安全侧的重视。

(责任编辑:时尚)

-

期待已久的2017双11晚会终于要来了,今晚7点40开启直播!那2017双11晚会看点有哪些呢?2017年双11晚会在哪里看直播?各位小伙伴们最想知道的就是这几个问题了,别担心哦,这里开淘小编在这里就

...[详细]

期待已久的2017双11晚会终于要来了,今晚7点40开启直播!那2017双11晚会看点有哪些呢?2017年双11晚会在哪里看直播?各位小伙伴们最想知道的就是这几个问题了,别担心哦,这里开淘小编在这里就

...[详细]

-

骁龙8至尊版性能对比Intel/AMD:比二代酷睿Ultra省电多达170%!

快科技夏威夷现场报道——骁龙8至尊版率先用上了高通自研的第二代Oryon CPU架构,不同于相比骁龙X Elite上的第一代面向PC笔记本设计,这次是针对智能手机移动平台设计的

...[详细]

快科技夏威夷现场报道——骁龙8至尊版率先用上了高通自研的第二代Oryon CPU架构,不同于相比骁龙X Elite上的第一代面向PC笔记本设计,这次是针对智能手机移动平台设计的

...[详细]

-

7月25日,比亚迪王朝全新中级SUV宋L DM-i在开封上市,新车基于新技术、新平台、新标准打造,百公里亏电油耗低至3.9L,满油满电综合续航超1500km,以“大宋”之名开创SUV油耗3时代,颠覆用

...[详细]

7月25日,比亚迪王朝全新中级SUV宋L DM-i在开封上市,新车基于新技术、新平台、新标准打造,百公里亏电油耗低至3.9L,满油满电综合续航超1500km,以“大宋”之名开创SUV油耗3时代,颠覆用

...[详细]

-

苹果中国官方多次降价后,iPhone 15的销量也是有了效果。据统计,iPhone15自发布以来,在各渠道连续多次降价,经历多轮价格跳水的iPhone15,全系销量提升,霸榜手机金榜前三。数据显示,本

...[详细]

苹果中国官方多次降价后,iPhone 15的销量也是有了效果。据统计,iPhone15自发布以来,在各渠道连续多次降价,经历多轮价格跳水的iPhone15,全系销量提升,霸榜手机金榜前三。数据显示,本

...[详细]

-

极氪MIX正式上市:首发搭载极氪超级座舱,售价27.99万元起

新浪科技讯 10月23日晚间消息,今日,极氪智能科技旗下家庭全场景大五座极氪MIX正式上市,包括智驾版和长续航智驾版两个版型,官方零售价分别为27.99万元和29.99万元,并同步开启全国交付。发布会

...[详细]

新浪科技讯 10月23日晚间消息,今日,极氪智能科技旗下家庭全场景大五座极氪MIX正式上市,包括智驾版和长续航智驾版两个版型,官方零售价分别为27.99万元和29.99万元,并同步开启全国交付。发布会

...[详细]

-

最强全大核既要又要!天玑9400 CPU实测性能猛增功耗大降

联发科最新发布的天玑9400再次刷新了旗舰芯片的性能标准,凭借第二代全大核架构,这款芯片在实测中展现了强劲的性能表现和惊人的能效优化。天玑9400搭载的CPU在Geekbench 6测试中单核得分超过

...[详细]

联发科最新发布的天玑9400再次刷新了旗舰芯片的性能标准,凭借第二代全大核架构,这款芯片在实测中展现了强劲的性能表现和惊人的能效优化。天玑9400搭载的CPU在Geekbench 6测试中单核得分超过

...[详细]

-

每天随机赠送100万美元成“二号公敌”!马斯克:我被暗杀的风险大增

快科技10月22日消息,据媒体报道,近日特斯拉CEO埃隆·马斯克在宾夕法尼亚州的一次公开活动中表示,自己被暗杀的风险正急剧增加。马斯克坦言:“参与政治并非我本意,我不想死,但我真的觉得我

...[详细]

快科技10月22日消息,据媒体报道,近日特斯拉CEO埃隆·马斯克在宾夕法尼亚州的一次公开活动中表示,自己被暗杀的风险正急剧增加。马斯克坦言:“参与政治并非我本意,我不想死,但我真的觉得我

...[详细]

-

新浪科技讯 10月22日下午消息,近日,滴滴自动驾驶宣布完成C轮2.98亿美元融资,本轮融资由广汽集团领投,滴滴参与。融资资金将用于加大自动驾驶技术的研发投入,加速推动首款Robotaxi量产车落地。

...[详细]

新浪科技讯 10月22日下午消息,近日,滴滴自动驾驶宣布完成C轮2.98亿美元融资,本轮融资由广汽集团领投,滴滴参与。融资资金将用于加大自动驾驶技术的研发投入,加速推动首款Robotaxi量产车落地。

...[详细]

-

导语:12月1日消息,2017年12月将有诸多影响生活方方面面新规开始执行,12月新规盘点。六地试点有奖发票上海最高奖金达40万元发票刮奖对于很多人来说并不陌生,从今天起,有奖发票再次推出,并在上海、

...[详细]

导语:12月1日消息,2017年12月将有诸多影响生活方方面面新规开始执行,12月新规盘点。六地试点有奖发票上海最高奖金达40万元发票刮奖对于很多人来说并不陌生,从今天起,有奖发票再次推出,并在上海、

...[详细]

-

新酷产品第一时间免费试玩,还有众多优质达人分享独到生活经验,快来新浪众测,体验各领域最前沿、最有趣、最好玩的产品吧~!下载客户端还能获得专享福利哦!2024年10月22日,福特汽车正式发布了其备受期待

...[详细]

新酷产品第一时间免费试玩,还有众多优质达人分享独到生活经验,快来新浪众测,体验各领域最前沿、最有趣、最好玩的产品吧~!下载客户端还能获得专享福利哦!2024年10月22日,福特汽车正式发布了其备受期待

...[详细]

A股港股同现二八定律是什么意思?股票“强者恒强”

A股港股同现二八定律是什么意思?股票“强者恒强” 高途CEO回应挖董宇辉:他是用来爱的,高途珍惜每一位人才

高途CEO回应挖董宇辉:他是用来爱的,高途珍惜每一位人才 福特购买小米SU7去美国:CEO开了六个月不想换

福特购买小米SU7去美国:CEO开了六个月不想换 油价调整最新消息 将呈现“十涨六跌六搁浅”格局

油价调整最新消息 将呈现“十涨六跌六搁浅”格局